#아이템 선정

#사업전략

#프로덕트

디지털 월세 절약하기: Ollama로 나만의 AI 비서 만드는 법

“다들 디지털 월세 얼마나 내시나요?”

최근 월 구독제 서비스의 증가로 '디지털 월세'라는 말이 유행하고 있습니다.

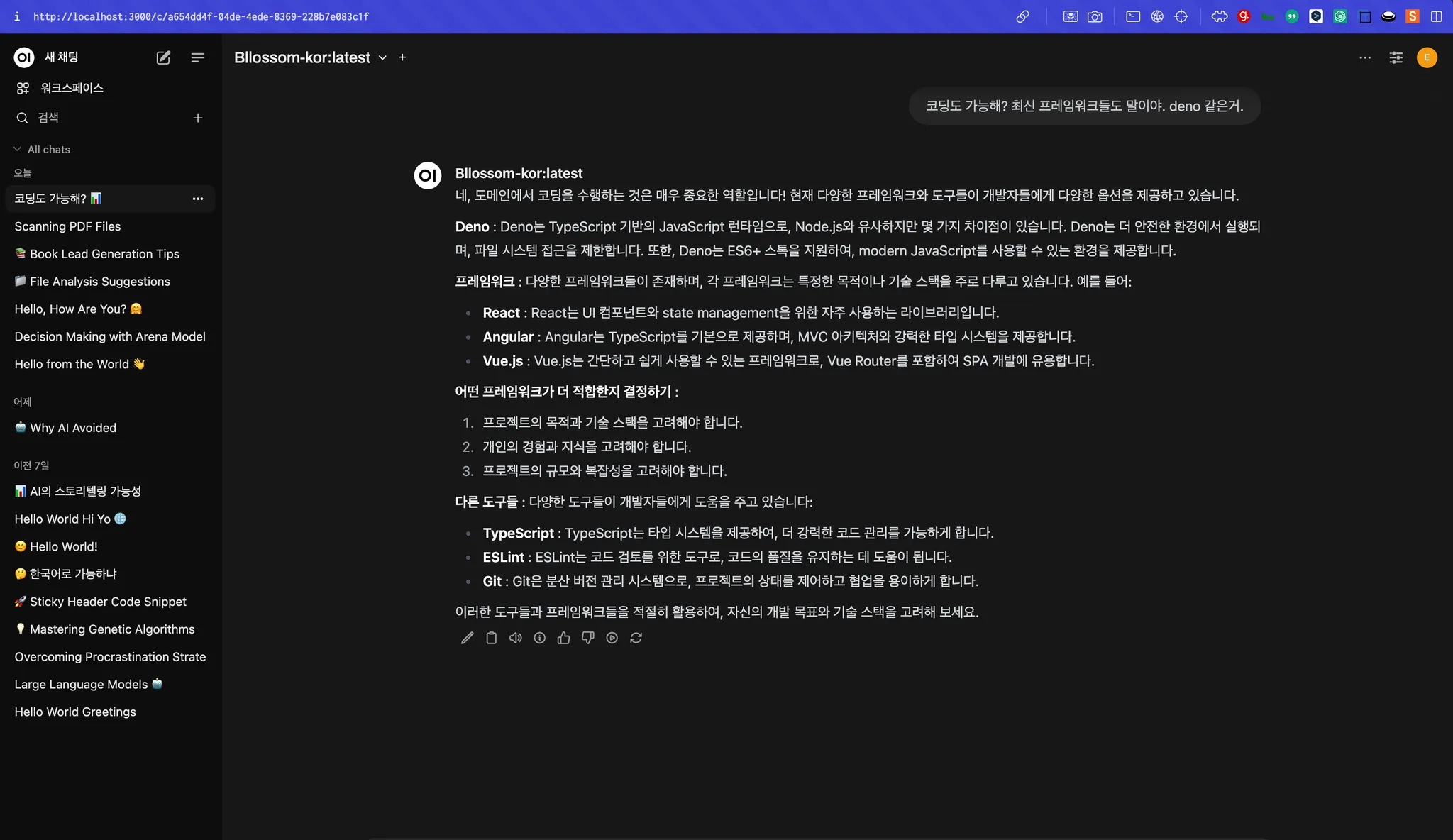

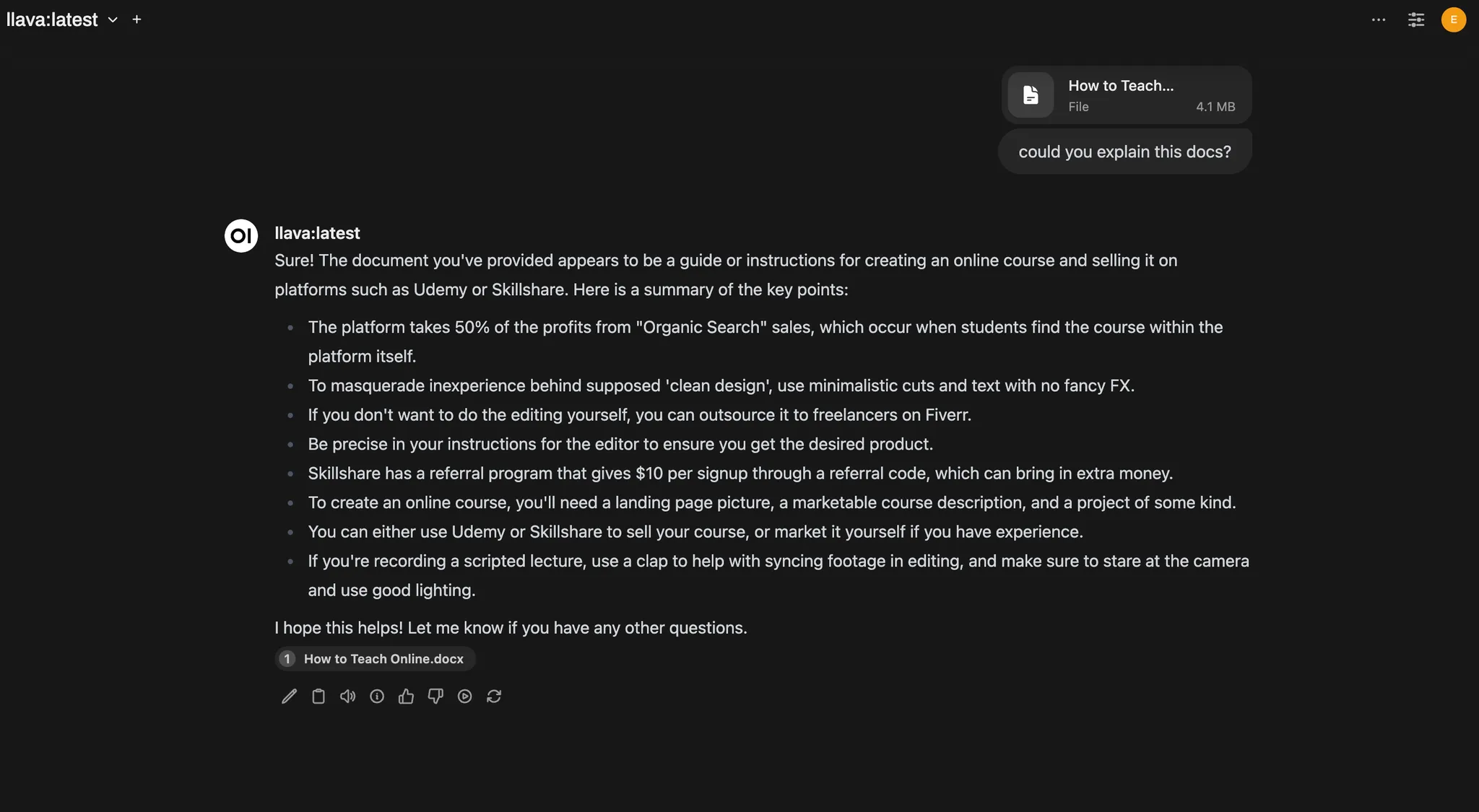

자연어 처리(NLP, Natural Language Processing)가 가능한 거대 언어 모델(LLM, Large Language Model)들이 공격적으로 출시되면서, ChatGPT를 시작으로 Claude, Gemini, Ollama 등 다양한 생성형 AI 제품이 쏟아져나오고 있습니다.

이로 인해 월 구독제에 대한 부담이 커졌죠. 최근에는 Cursor가 시장 점유율을 높여나갔고, Github Copilot에 Claude 3.5 모델이 탑재된다고 합니다. 생성형 AI 모델뿐만 아니라 AI Wrapper라 불리는 ChatGPT나 Claude 모델을 활용한 서비스나 제품이 더욱 보편화될 것으로 예상됩니다.

댓글이 없습니다.

추천 아티클